- 查看robots.txt有没有禁止抓取语句

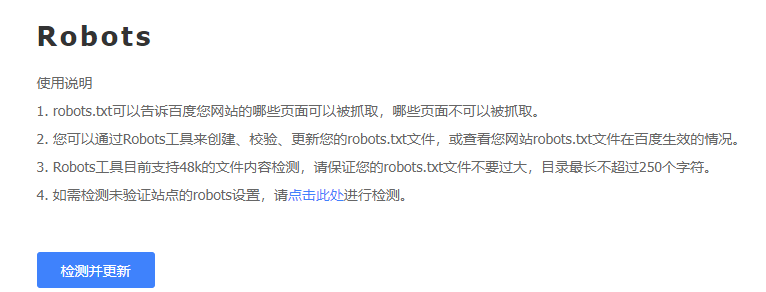

首先我们要检查robots.txt中是否有禁止抓取语句 可以用百度自带的工具检测

可以用百度自带的工具检测 - 更换DNS解析

因为一般抓取失败都是提示DNS无法解析IP的问题,新站可能过两天就会好了,我的就是这样 - 网站是否打不开,服务器不稳定,防火墙蜘蛛屏蔽

第三点就是我们网站自身的问题,有时候会出现卡顿,导致蜘蛛抓取不成功,大家可以自己手动进行网站测速,然后在稳定性比较好,确认可以打开网站的情况下去测试蜘蛛的抓取,一般这种情况下,虚拟主机问题比较多。 - 百度异常,查看日志是否有蜘蛛进来抓取

如果以上方法都试过,但是你的抓取依然失败的话,不排除百度本身的问题,你可以通过日志看每天是否有蜘蛛来,如果有,而且很规律很正常,就可以不必理会百度后台的蜘蛛抓取了。

版权属于:

Ezra

作品采用:

《

署名-非商业性使用-相同方式共享 4.0 国际 (CC BY-NC-SA 4.0)

》许可协议授权

评论